Алгоритмы лежат в основе принятия больших и малых решений в массовом масштабе каждый день: кто проходит обследование на наличие таких заболеваний, как диабет, кому делают пересадку почки, как распределяются ресурсы полиции, кто видит объявления о поиске жилья или работы, как рассчитываются показатели рецидивизма и так далее. При определенных обстоятельствах алгоритмы — процедуры, используемые для решения проблемы или выполнения вычислений, — могут повысить эффективность и беспристрастность принятия решений человеком.

Однако те самые стандарты, которые были разработаны для того, чтобы сделать алгоритмические решения “справедливыми”, на самом деле могут укоренять и усугублять неравенство, особенно по расовому, этническому и гендерному признакам. В этом суть статьи “Разработка справедливых алгоритмов”, опубликованной на этой неделе в журнале Nature Computational Science адъюнкт-профессором права Стэнфорда Джулианом Ньярко, исполнительным директором лаборатории вычислительной политики Стэнфорда Алексом Чохлас-Вудом и соавторами из Гарвардского университета.

По мнению авторов, с распространением алгоритмически управляемого процесса принятия решений практически во всех аспектах жизни возрастает потребность в обеспечении того, чтобы использование алгоритмов при принятии важных решений не приводило к непреднамеренным негативным последствиям.

“Лицо, принимающее решения, может определить критерии того, что, по его мнению, является справедливым процессом, и строго придерживаться этих критериев, но во многих контекстах оказывается, что это означает, что в конечном итоге они принимают решения, наносящие вред маргинализированным группам”, – сказал Ньярко, который уделяет большую часть своей научной работы тому, как вычислительные методы могут быть использованы для изучения вопросов, имеющих юридическое и социально-научное значение.

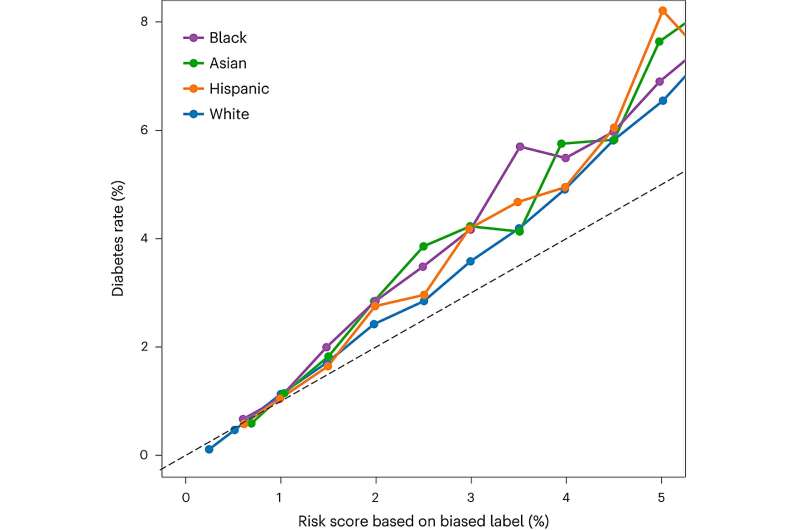

Ньярко привела в качестве примера скрининг на диабет. “Алгоритмы используются в качестве первого фильтра для определения того, кто проходит дальнейшие тесты. Мы знаем, что, учитывая определенный ИМТ и возраст, пациенты, которые идентифицируют себя как азиаты, как правило, имеют более высокие показатели диабета, чем те, кто не идентифицирует себя как азиаты. Алгоритм, имеющий доступ к расовой принадлежности пациента, может использовать эту информацию и быть соответственно более снисходительным при принятии решения о направлении, если пациент идентифицирует себя как азиат.

“Однако, если мы настаиваем на принятии решений без учета расовой принадлежности, мы затрудняем алгоритму использование этой информации и корректировку его прогнозов для азиатских пациентов. В конечном счете, это означает, что алгоритм, не учитывающий расовую принадлежность, хотя и может быть “справедливым” в техническом смысле, исключает из дальнейшего тестирования некоторых азиатских пациентов с явно высоким риском развития диабета. Аналогичный компромисс между тем, что мы могли бы назвать справедливым процессом, и справедливыми результатами применим к наиболее популярным критериям справедливости, которые часто используются на практике.”

По его словам, подобные результаты хорошо известны в литературе по алгоритмическому принятию решений. Однако введение строгих критериев справедливости остается популярным как среди исследователей, так и среди практиков. “Мы считаем, что этот факт подчеркивает необходимость активного обсуждения того, почему те, кто выступает за использование ограничений справедливости, делают это”, – сказал Ньярко.

“Точно ли формальные критерии справедливости отражают взгляды людей на то, что значит принимать этическое решение, и поэтому должны ли они быть включены? Является ли соблюдение “справедливого” процесса принятия решений – например, такого, в котором не учитывается расовая принадлежность, — желательным само по себе, или это просто полезная эвристика, которая часто приводит к более справедливым результатам? Только если у нас будет ясность в этих нормативных и этических вопросах, мы сможем надеяться на прогресс в понимании того, что значит для алгоритмических решений быть справедливыми. Надеюсь, это также приведет к большей однородности подходов”.

Создание основы для разрозненных дебатов

Ньярко подчеркнула, что многочисленные исследования, особенно в медицинском контексте, изучали влияние введения ограничений справедливости, таких как решения, нейтральные по расовому или гендерному признаку. Новый документ призван “придать объединяющую основу этим дискуссиям”, – сказал он. “Вы видите множество отдельных статей, разбросанных по дисциплинам, которые затрагивают вопросы алгоритмической справедливости, но мы считаем, что дискуссия нуждается в структуре, и это то, чего мы намеревались достичь”, – сказал он. “Я думаю, что многие из этих индивидуальных дискуссий не были хорошо связаны с более широкими этическими дискуссиями о справедливости”.

В документе рассматривается каждое из трех наиболее типичных ограничений справедливости, все из которых “интуитивно привлекательны”, но которые могут привести к результатам, неблагоприятным для отдельных людей и общества в целом, пишут они. Ограничениями справедливости являются:

Ослепление, при котором человек ограничивает влияние демографических характеристик — например, расы — на принимаемые решения

Выравнивание показателей принятия решений по демографическим группам (например, требование, чтобы доля пациентов, направленных на дальнейшее тестирование на диабет, была одинаковой для пациентов азиатского и неазиатского происхождения)

Выравнивание частоты ошибок по демографическим группам (например, требование, чтобы доля пациентов, ошибочно исключенных из тестирования, даже если у них диабет (так называемый показатель ложноотрицательных результатов), была одинаковой для азиатских и неазиатских пациентов)

В документе предлагается несколько рекомендаций для людей, обучающих алгоритмам для помощи в принятии решений, в том числе о том, чтобы они понимали подводные камни “предвзятости ярлыков”.

“В литературе по машинному обучению очень широко распространено убеждение, что предоставление большего количества данных алгоритму не может причинить никакого вреда”, – сказал Ньярко. “Либо информация полезна для составления прогноза, либо она отбрасывается. Но это верно только в том случае, если то, чему мы обучаем алгоритм для предсказания, – это то, что нас действительно волнует. Однако оказывается, что эти два понятия обычно расходятся.

“В контексте уголовного правосудия, например, судья, который принимает решение о заключении под стражу, может захотеть знать, насколько велика вероятность того, что обвиняемый совершит рецидив. Это поможет судье решить, должен ли подсудимый оставаться в тюрьме или может быть освобожден. Алгоритмы обычно помогают судьям в принятии таких решений. Однако эти алгоритмы никогда не были обучены предсказывать вероятность рецидива. В конце концов, совершает ли кто-то преступление – это не то, что действительно можно наблюдать в масштабе.

“Все, что мы знаем, и все, чему обучен алгоритм для прогнозирования, – это вероятность повторного ареста обвиняемого. Будет ли кто-то повторно арестован за преступление, может в значительной степени зависеть от того, много ли полиции присутствует в районе, где он проживает. Этот тип смещения меток очень распространен, и мы показываем, что он имеет важные последствия для того, как следует обучать алгоритмы.

“Например, в нашем примере прогнозирования риска рецидива мы показываем, что предоставление доступа к почтовому индексу обвиняемого широко используемым алгоритмам улучшает их прогноз относительно того, будет ли обвиняемый повторно арестован. Однако из-за различий в работе полиции в разных районах предоставление доступа к почтовым индексам ухудшает способность одних и тех же алгоритмов предсказывать, совершит ли обвиняемый рецидив. В более общем плане наши результаты ставят под сомнение общепринятую точку зрения о том, что добавление большего количества данных не может ухудшить наши алгоритмические решения”.